一、背景说明

本文探讨的GPU报错信息主要收集于数据中心、多机多卡满负载场景。主要面向服务器厂商的维护团队、售后一线同事或者终端使用客户的问题排查和定位。

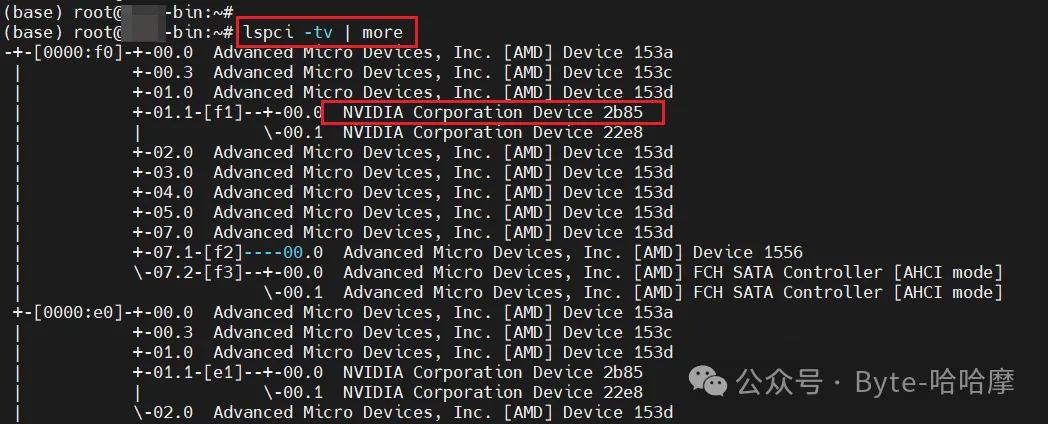

推荐搭配 lspci -tv、nvidia-smi topo -m分析硬件topo。

二、常见GPU错误信息

说明:本章节仅展示作者在日常使用及问题定位过程发现的错误信息(具体问题的分析结果、根本原因等暂不方便展开描述勿怪)。

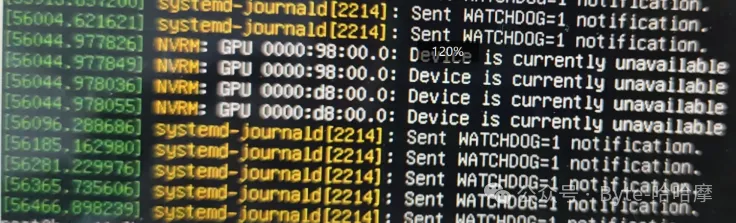

- GPU Device is currently unavailable

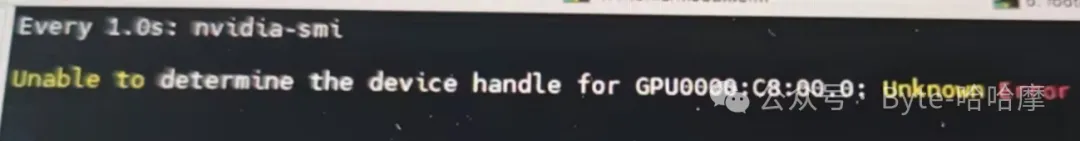

- Unale to determine thr device handle for***

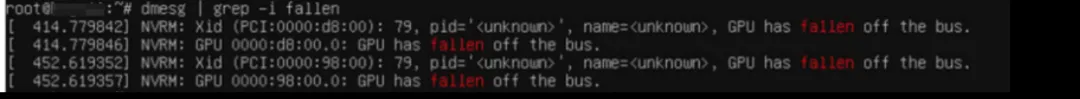

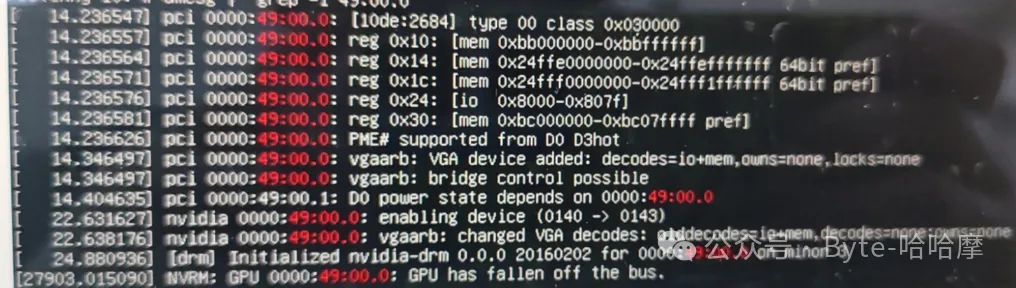

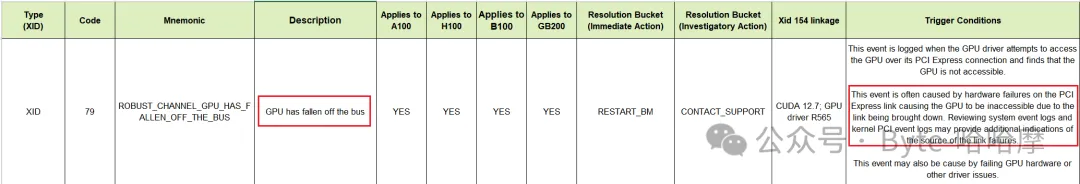

- GPU has fallen off the bus(xid 79)

本错误较为致命,属于物理链路上的设备丢失,需重点关注分析。

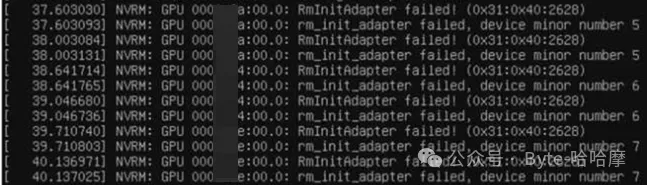

- GPU BDF RmInitAdapter failed

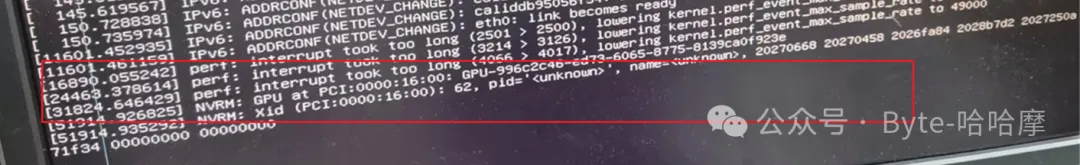

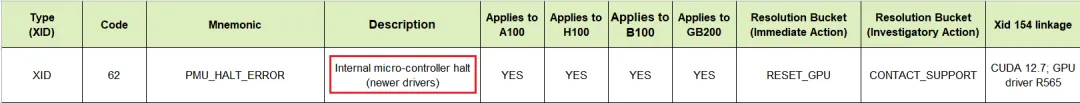

- GPU at BDF *** (xid 62)

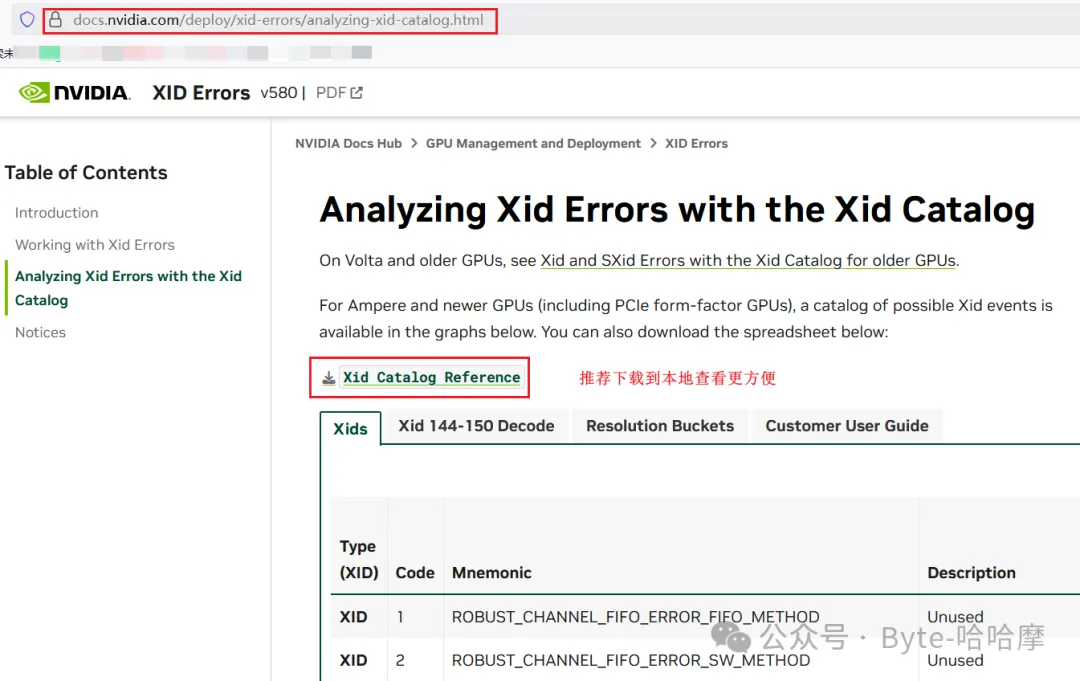

三、NVIDIA 错误码XID Erros

官网网址:https://docs.nvidia.com/deploy/xid-errors/analyzing-xid-catalog.html 推荐将文档下载到本地检索使用。

四、常规GPU问题分析思路

(很重要)保留第一现场,即遇到报错或者弹出告警信息的时候,第一时间截图或者拍照保留(同样不要立马使用重启大法直接重启恢复);

查看demsg对应打印,推荐关注dmesg最后的日志打印,然后根据需要反正往上看,直到报错开始的日志打印处;

如果报错信息中存在第二部分展示的部分xid相关的错误码信息,可以自行对比xid表格,找出问题具体指向硬件链路还是软件层;

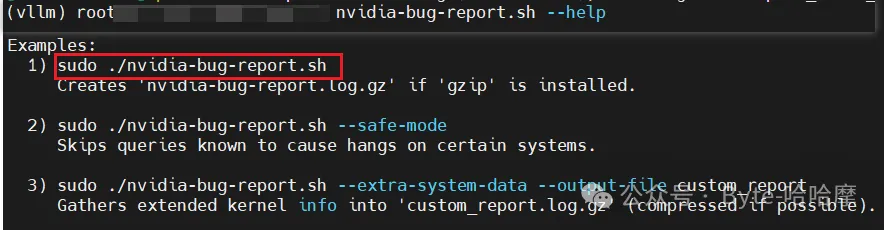

执行 nvidia-bug-report.sh 日志收集脚本(装完NVIDIA驱动之后就可直接tab出来使用)然后就会Creates 'nvidia-bug-report.log.gz' if 'gzip' is installed;

在服务器的web管理页面进行一键日志下载(需要传递给服务器厂商进行解读分析);

如果必需的日志收集完成,可以选择进行服务器重启(如有业务部署的GPU服务器重启需注意呀)进行问题复现(重启也分DC和AC),找出问题的触发条件从而进一步进行分析定位。